Как не допустить дублированный контент в WordPress

Сама проблема дублированного контента возникла недавно, когда поисковики стали наказывать сайты за использование дублированного контента. Давайте разберемся в начале, что такое дублированный контент?

Дублированный контент – одинаковый текст или часть текста, к которому можно обратиться по разным URL. Дублированный контент может располагаться как в пределах одного ресурса, так и на просторах всего интернет.

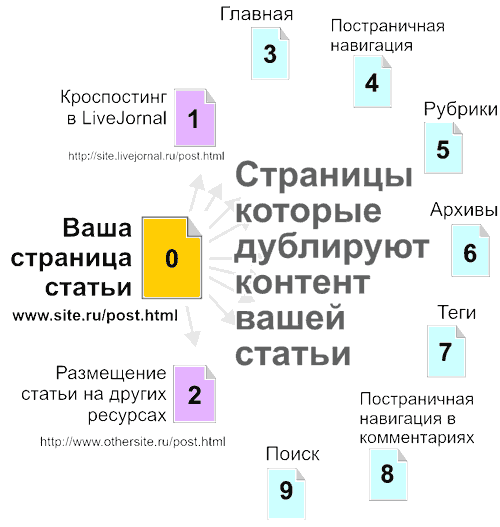

Проиллюстрирую:

- Ссылка на созданный пост имеет вид http://www.site.ru/post.html

- Многие блоггеры используют кроспостинг для повышения тематической ссылочной массы и для быстрой индексации, возьмем, к примеру, бесплатные блоги на livejornal, ссылка будет выглядеть так: http://site.livejornal.ru/post.html

- Если у вас украли статью или вы сами разместили ее на каком-либо ресурсе с обратной ссылкой, опять же тот же текст можно прочесть по новой ссылке: http://www.othersite.ru/post.html

- Часто на главной странице своего сайта выводят несколько последних статей в полном виде. Получается дубль текста вашего поста по ссылке: http://www.site.ru/

- Если статей много, то создается постраничная навигация, новые статьи вытесняют старые статьи на последующие страницы. Если вы используете полный вывод статьи на главной, то ваш пост можно будет прочитать по ссылке: http://www.site.ru/page.html/page/2

- Такая же ситуация, как и с главной страницей, и для Рубрик сайта. Если вы отдаете статьи полностью в Рубрики, значит, появляется новая ссылка со страницы рубрики: http://www.site.ru/category/

- Страницы архива также, как и рубрики, дублируют контент: http://www.site.ru/2010/, но при этом, даже если у вас выводится часть статьи или цитата, то в архиве вы все равно получите дублирующую ссылку вида: http://www.site.ru/2010/post.html

- Страницы тегов полностью аналогичны страницам рубрик: http://www.site.ru/tag/nametag/

- В этот комплект дублей добавляет еще свою ссылку Поиск по сайту: http://www.site.ru/?s=search

- И даже на самой странице поста можно получить как минимум 2 ссылки, дублирующих контент:

1. Ссылка появляется при большом количестве комментариев и включении режима постраничной навигации по комментариям, вида: http://www.site.ru/page.html/comment-page-1#comments

2. Ссылка появляется если у вас длинная статья, и вы решили разделить ее на несколько частей тегом <!—nextpage—>, который вставляет постраничную навигацию еще в сам пост. Ссылка на 2 страницу поста будет иметь вид: http://www.site.ru/page.html/2

Что в результате?

В результате, при неумелом пользовании функционалом WordPress, вы рискуете получить как минимум 8 дублирующих ссылок одной статьи внутри самого ресурса + дубли с размещения статей на внешних ресурсах.

Как правильно настроить и организовать ваш блог на WordPress, не создавая дублированного контента?

Начнем по порядку пунктов указанному выше:

- На страницах постов, статических страницах, всегда используйте мета-тег rel=’canonical’. Он позволяет указать поисковикам правильный источник контента внутри сайта и для многих внешних ресурсов.

- Старайтесь при кроспостинге, все-таки не отдавать всю статью ресурсу. Урежьте ее как минимум до 50%. Обязательно проставляйте ссылки на источник, 2-3 штуки, с разными анкорами. Если есть возможность изменять на мета-теги на кроспостинговом ресурсе, уберите мета-тег rel=’canonical’.

- Если вы размещаете статью на внешних ресурсах и нет возможности ее уникализировать, действуйте по принципу п.1 + измените хотя бы некоторые абзацы вашего текста. Обязательно проставляйте обратные ссылки на вашу статью – источник и сам блог. Эта рекомендация часто помогает при воровстве контента. Т.к. многие воры копируют контент на автомате,специальными скриптами и в большинстве случаев ссылки не затираются.

- Практически с самого начала существования WordPress, разработчиками был продуман функционал, который позволял вывести на главной текст на вашу статью без дублирования контента.

Зайдите на страницу редактора в админ – панели WordPress. На странице, под самим редактором найдете вкладку «Цитата (Excerpt)». Вот она и предназначена для вывода анонса статьи на главной, в рубриках, архиве, поиске и т.д. При создании статьи используйте это поле для создания уникального анонса статьи, который будет мотивировать посетителя кликнуть по ссылке «Читать далее» и прочесть вашу статью.

Кроме исключения дублей у поля «Цитата», есть еще одна полезная особенность, этот текст вы можете оптимизировать под ключевые слова необходимые для Главной, Рубрики и т.д. - Постраничную навигацию, навигацию по комментариям, Архивы, Теги, поиск по сайту лучше всего закрыть от индексации в robots.txt:

Disallow: */comments*

Disallow: /search

Disallow: /?s=*

Disallow: /author/*

Disallow: /tag/*

Disallow: /trackback

Disallow: /20*/*

Disallow: /page/*

Disallow: /comment-page*

Disallow: /*?replytocom*

- От дублирования контента в Рубриках избавляемся тем же способом, как и для Главной страницы блога. Либо закрыть и ее от индексации. Решать вам.

- Осталась одна ссылка – дубль, возникающая при разделении страницы на части и создающая постраничную навигацию для самого поста. Как с ней бороться, пока не знаю. Мой совет, постарайтесь не использовать этот функционал. Лучше разделите статью на реальные части и создайте для каждой части отдельный пост.

При шаблонном подходе, на страницах вашего сайта вы всегда найдете дублирующий контент.

Например:

- Виджеты в сайдбаре

- Шапка и подвал сайта

- Какие-то вставки в самом посте.

Важно, чтобы на каждой странице внутри вашего сайта, всегда были уникальны:

- Заголовок страницы (title).

- Мета – тег описания страницы (description).

- Как минимум (мое мнение) 50% совокупного текстового наполнения страницы.

Все остальные страницы сайта, которые формируют свой контент на основании текста самих постов, должны быть закрыты от индексации.

При таком подходе, у вас наименьшие шансы получить наказание от поисковиков за дублированный контент.

Мифы связанные с дублированным контентом:

- Ссылка с «якорем» типа http://www.site.ru/page.html#якорь создает дублированный контент для поисковиков.

Это утверждение не верно, т.к. данный якорь всего лишь позиционирует страницу в окне браузера при переходе по ссылке и не является динамическим параметром. Поисковики давно уже научились отличать «якоря» от динамических параметров ссылок. Поэтому использование ссылок «Читать далее» в WordPress более чем безопасно. - Новый мета-тег <link rel=’canonical’ href=’ http://www.site.ru/page.html ‘ /> спасет весь мир и решит проблему дублированного контента.

К сожалению и это утверждение не верно. Представьте ситуацию, когда вы создали статью, а кто-то ее украл в течении часа, например используя ваш RSS, и разместил у себя на новой странице сайта. У него также появится мета-тег rel=’canonical’. Если рейтинги вашего сайта примерно одинаковые, как вы думаете, как поисковики определят первоисточник? Тот к кому придет первым робот, тот и будет в выигрыше. Стопроцентного решения данной проблемы нет. Если для вас это важно, Google вам в помощь.

Данный мета-тег скорее помогает решить проблему с дублированным контентом в пределах одного ресурса. Используя собирающие страницы сайта (рубрики, архивы, теги, поиск по сайту, главная) важно следить, чтобы у этих страниц данный тег отсутствовал. Тогда, присутствие rel=’canonical’ только в страницах статей дает весомые гарантии уникальности вашего контента. - Рерайт или синонимизация сделает текст уникальным.

К счастью, поисковики научились распознавать и рерайт. Большинство сайтов использующих рерайт, банят в течении 1-2 месяцев. Я одно время увлекся рерайтом, даже купил не дешевый софт. Мое мнение, качественный и быстрый рерайт, на сегодняшний день, написание новой – уникальной статьи на ту же тему. Все остальное — впустую потраченное время.

Спонсор поста:

Агентство «ИДЕАЛ» – один из лидеров современного рынка поискового продвижение сайта в Украине.

P.S. В этой статье, я старался доступным языком объяснить, что такое дублированный контент в WordPress и как от него можно избавиться внутренним функционалом платформы. Если я что-то упустил или вы знаете еще проблемные места в WordPress, создающие дублированный контент, добро пожаловать в комментарии.

Жду ваших вопросов.

Нашел ошибку в тексте? Выдели ее мышкой и нажми

- СТАТЬИ ПО ТЕМЕ

- ЕЩЕ ИЗ РУБРИКИ

- ПОПУЛЯРНЫЕ

КОММЕНТАРИИ К СТАТЬЕ